当前,全球数字经济正逐渐向以人工智能(AI)为核心驱动力的智能经济新阶段迈进。AI技术在各行业得到广泛应用,但在为经济和社会发展注入新动能的同时,也带来了监管难题。为此,2021年4月,欧盟发布《人工智能法》提案(以下简称《法案》),提出了AI统一监管规则,旨在从国家法律层面限制AI技术发展带来的潜在风险和不良影响,使AI技术在符合欧洲价值观和基本权利的基础上技术应用创新得到进一步加强,让欧洲成为可信赖的全球AI中心。作为AI领域的“GDPR”,该《法案》是全球首部AI管制法律,研究其内容和创新点,对制定我国AI等数字技术治理方案具有重要借鉴意义。

《法案》核心内容

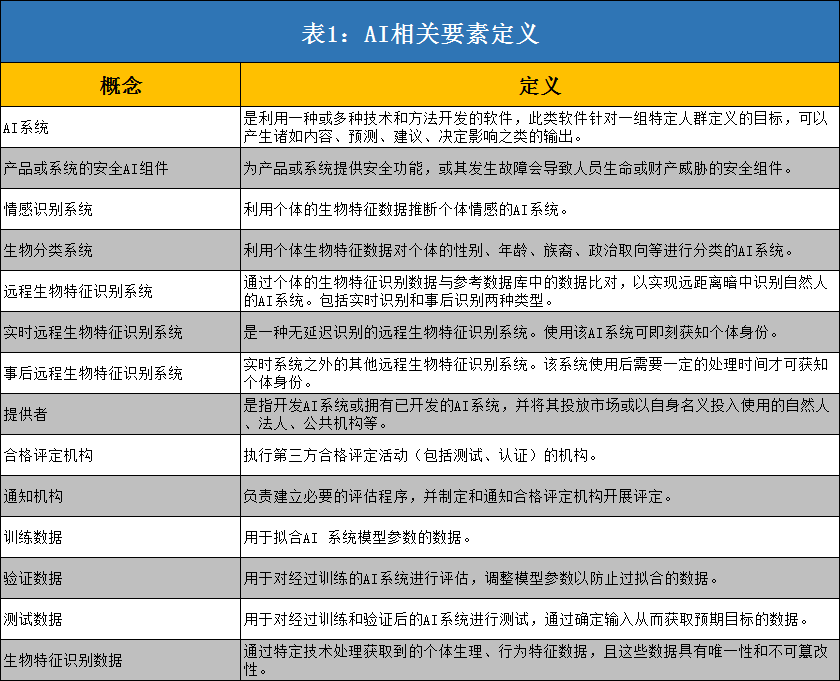

宽泛定义了AI系统,并设置了AI规则的域外适用性。一方面,《法案》定义了AI系统、AI系统供应链上涉及到的相关环节以及不同类别的AI数据等相关要素,对监管对象(AI系统)的定义表现出极强的宽泛性,几乎涵盖了全部使用传统及新兴AI技术的系统(AI技术使用常态化的互联网服务均为监管对象),与GDPR中对受监管的个人数据的宽泛定义保持一致。另一方面,《法案》明确了所有在欧盟市场投放、使用AI系统及相关服务的国内外供应商、服务商和公共服务用户提供者,只要其AI系统影响到欧盟及欧盟公民的,均将受到《法案》约束,从而保证了AI规则的域外适用性。

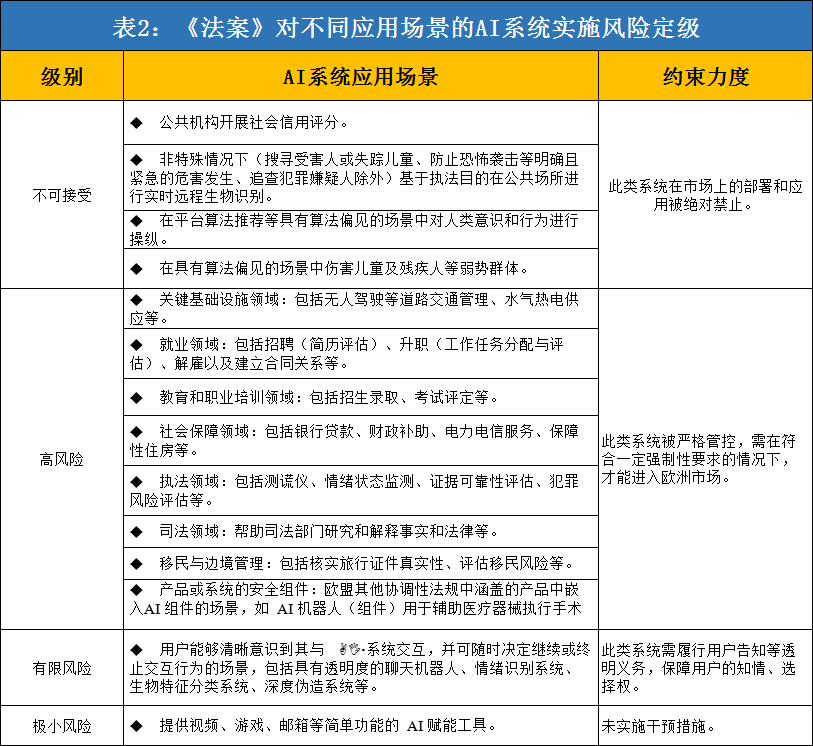

对不同应用场景的AI系统实施风险定级,并分别提出规制路径。《法案》基于不同应用场景的风险差异性,将AI系统分为“不可接受、高、有限、极小”四个风险等级,并针对不同级别风险实施不同程度的规制,从而构建起以风险为基础的四级治理体系。一是将对基本人权和社会公平构成明显威胁的AI系统视为“不可接受”;二是将可能危及公民人身安全及生活基本权利场景中的AI系统视为“高风险”;三是将具有特定透明度义务的AI系统视为“有限风险”;四是将提供简单工具性功能的AI系统视为“极小风险”。

为在特定领域提供“高风险”AI系统的企业提出“全生命周期”式的多重合规要求,旨在增强AI产品及服务的透明度。《法案》重点对“高风险”AI系统的开发、部署和应用等全生命周期提出了系列规范,并要求企业等AI系统供应商履行以下透明化义务:一是在AI系统开发过程中,建立风险管理系统、进行数据质量检验、设计用户告知和日志追溯功能、搭建网络安全保障能力、编制用于监管审计的技术信息文件等。二是在AI系统首次运营前或系统升级迭代后,及时开展合规性评估,并在欧盟委员会建立和管理的大数据库中进行备案登记。三是在AI系统投入使用过程中,建立与AI风险级别相匹配适应的售后监测系统与人为监督机制,对AI应用中的风险进行监控预警,在发现可能的风险后召回系统处理并通知相关监管机构。四是在AI系统发生故障或严重事故时,应立即采取补救措施,并在半个月内向相关监管部门报告。

设立专项AI监督机构,加大监管执法力度。在AI监管主体方面,《法案》提出将通过建立欧洲人工智能委员会,推动AI新规则的实施完善,以及后续AI标准的制定出台,并借此构建各国监管部门的联络渠道,协调欧盟层面的AI监管政策,以保持AI监管体系的统一性。此外,要求各成员国建立通知机构,指定和通知第三方合格评定机构开展监管评估,并定期将监管调查信息发送至AI委员会。在AI监管执法方面,《法案》提出将对创建或应用AI系统过程中的违法企业处以高达约3600万美元的行政罚款,或全球年度总营业额的2%-6%,取两者中最高的金额进行处罚。相比GDPR中4%年营业额的罚款金额,《法案》的AI监管处罚力度进一步加大。此外,将撤回未在规定时间内实施整改措施企业的AI系统,并限制其市场销售。

《法案》亮点分析

与GDPR有效衔接,进一步明确了AI系统的数据治理要求。数据和算法是AI技术的核心要素,AI系统通过数据喂养进行算法模型优化,算法模型也应用于对个人数据的深度挖掘,实现基于学习的智能化服务。为此,《法案》重点关注了AI系统的数据安全和算法歧视偏见等问题,并进行了明确规制,包括:AI系统在收集用户数据前需履行告知义务,以保证用户的知情权和选择权,确保数据采集的合法性;在训练、验证、测试“高风险”AI系统数据集时,应完成数据质量检验、算法偏见评估检查等要求;在AI监管沙盒中处理个人数据时,应保证个人数据均处于功能独立、隔离且受保护的数据处理环境中,并需实施授权访问和数据删除机制。

搭建具备可拓展性的法律框架,弥补了技术监管的滞后性缺陷。面对飞速发展的AI等新兴数字技术,法律的适用性持续时间往往较短,新制定的法律规定可能很快就无法适用于实际情况,难以实现对迭代快速的AI技术进行全面监管,AI领域的法制体系滞后性凸显。为此,《法案》专门预留了及时调整更新法律的空间,通过设臵“动态清单”,巧妙化解了法律滞后性和技术飞速发展之间的矛盾。例如,对AI系统的定义,《法案》以附件形式详细列举了属于AI范围内的技术和方法清单,并通过更新清单机制,保持与最前沿AI技术的同步性;针对“高风险”AI系统的界定,《法案》制定了“高风险”清单,并赋予人工智能委员会结合风险多边性判断并提出添加新“高风险”应用场景建议的权利,以确保法律的及时更新。

实施对人工智能系统的分类分级监管,构建系统性AI治理体系。AI技术具有跨学科、前沿知识融合等复杂属性,不同AI系统在相同场景中可造成不同种类的风险,相同AI系统在不同场景中应用也可能带来不同种类或不同程度的风险。为此,《法案》采用分类分级思路,在梳理重点应用场景类别的基础上,对不同应用场景按照AI系统风险可能的影响程度和危害性质实施不同等级的分类治理,替代对不同场景的AI风险进行分散专项治理的传统路径。通过构建清晰且系统性的治理框架,实现对AI系统复杂性风险的“降维”治理。

率先建立AI监管沙盒机制,探索监管人工智能风险的新模式。技术规制的法律制定常见难点之一就是如何在实现有效监管的同时,兼顾技术创新发展,鼓励企业负责任的创新行为。为此,《法案》提出通过建立AI监管沙盒,为AI系统的开发、部署、验证、测试提供了一个可控的隔离环境,使欧洲企业可在免责条件下进行AI相关的试验和创新,且试验全过程受到监管部门的监督。通过在可控范围内实行容错纠错机制,在杜绝AI未知问题向不可控外部环境扩散风险的同时,也为AI创新企业创造了相对宽松的发展环境。

四点启示

强化AI立法,制定具备衔接性与灵活性的法律监管框架。基于AI风险的复杂性、多变性,以及其与数据安全的紧密关联性,在探索AI法律规制路径时,可参考欧盟《法案》亮点,增强法律内容的衔接协调与灵活开放特性。一方面,确保AI法律与《网络安全法》、《民典法》、《数据安全法》、《个人信息保护法(草案)》四项数据和个人信息保护基本法的有效衔接,明确AI语境下的数据安全及个人隐私保护原则,规制AI数据安全风险。另一方面,针对AI技术、“高中低”风险应用场景等具有变化特征的概念实施动态定义,通过设臵清单列表并建立类数据库功能的“增删改查”调整机制,确保法律在技术发展和场景变更下的时效性和灵活性,防止AI法律内容滞后带来的监管困境。

探索分类分级监管路径,依据不同应用场景精准施策。可考虑采用《法案》中的分类分级治理思路,依托对不同场景类别的梳理,以及场景风险对个人生命和生活权利、社会秩序影响大小,将不同应用场景进行分级,对归属于同一风险级别场景中的AI系统进行统一管控,对不同风险级别场景中的AI系统分别采取具有不同约束程度的治理方式,从而建立起自下而上限制逐步加深的“风险金字塔”规制模型。尝试以“风险金字塔”为抓手,构建系统精准的AI监管治理体系,解决长久以来面临复杂多样的AI系统风险时监管效能低下的困境。

明确企业在AI产品开发、运营过程中的强制性义务,提高AI系统的透明度。要求企业在AI产品开发过程中,建立完善的AI系统风险管控流程,包括开展数据质量检验避免数据投毒等事件发生、建立日志追溯机制强化风险的归因溯源、建设网络安全保障能力防止数据泄露等;在AI产品投入市场使用前或系统改造后,定期通过第三方评估机构开展评估认证,向监管部门备案AI算法的设计运行机制、可能的偏见和漏洞、AI数据安全保护和风险管控措施;在AI产品投入使用后,及时开展监控预警,建立应急响应机制,及时处理可能的AI风险事故并同步监管部门。

多措并举构建体系化的AI监管机制,制定包容审慎的技术监管措施。一是建立AI监管专项负责机构,及时跟踪和制约AI风险。AI监管机构负责跟踪AI技术发展和应用场景变化,及时提出AI新风险应对、监管范围更新等相关建议;对各类不负责任的AI提供者实施约谈处罚,进行有效制约和威慑。二是完善标准体系,建立第三方机构开展AI风险检测认证。加快制定AI相关技术和应用的安全标准,明确各领域AI系统的审计、日志、告知等透明性要求与衡量指标;培育权威的第三方AI风险评估机构,开展AI算法、透明度、数据安全风险等相关评估。三是探索设立AI沙盒监管,探寻风险制约和创新保护之间的最佳结合点。建议由AI监管的专项负责机构确定沙盒监管基本原则和条件,将具备创新性但风险未知的AI产品或商业模式在进入市场前,预先在沙盒环境进行迭代验证,使用户在受保护的环境使用AI产品或服务。

登录

登录